时间:2025-08-24 05:21 2188人阅读

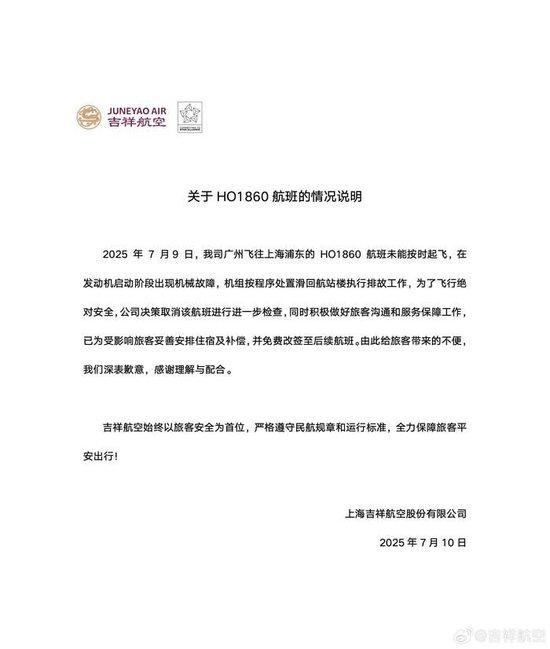

7月10日,@吉祥航空 发布关于7月9日HO1860航班情况的说明:7月9日,公司广州飞往上海浦东的HO1860航班未能按时起飞,在发动机启动阶段出现机械故障,机组按程序处置滑回航站楼执行排故工作,为 ...[详细]

时间:2025-08-24 05:16 2177人阅读

北京深谋科技有限公司近日发布了一款业界罕见的高精度压电式六维力传感器,名曰 “弹起” ,特别适配服务机器人、人形机器人、航空航天、医疗、工业自动化等对环境高动态交互和多维力控制要求极高的场景。该产品具 ...[详细]

时间:2025-08-24 05:15 2843人阅读

来源标题:逃离都市的秘境体验:安岚秘境音乐派对如何征服高端度假客群?这个夏天,宁海安岚以一场沉浸式音乐活动,精准击中了高端客群对“小众”“深度”&ldq ...[详细]

时间:2025-08-24 05:05 2268人阅读

今天凌晨,奥特曼突然发文宣布推出自家最新的 o 系列模型:满血版 o3 和 o4-mini,同时表示这两款模型都可以自由调用 ChatGPT 里的各种工具,包括但不限于图像生成、图像分析、文件解释、网 ...[详细]

时间:2025-08-24 04:59 2033人阅读

来源:财联社财联社7月10日电,据新华社报道,也门胡塞武装9日发表声明称,该组织的武装部队击沉了在红海航行的希腊货轮“永恒C”号。这是该组织4天内在红海击沉的第二艘货轮。据胡塞武装旗下的马西拉电视台报 ...[详细]

时间:2025-08-24 04:51 2320人阅读

2 月 16 号,马斯克在 X 上发布了一条自家 Grok 3 模型的发布预告。并配文“地球上最聪明的 AI”要来了。北京时间 2025 年 2 月 18 日中午,马斯克如约带领着 xAI 的工程师和 ...[详细]

时间:2025-08-24 04:28 2776人阅读

人工智能无疑是当前最为热门的科技概念。作为科技界的领军企业,微软在人工智能领域耕耘已久。早在25年前微软研究院建立时,人工智能就已经成为整个微软的战略目标。微软为此倾注了许多精力和资源,并取得了亮眼的 ...[详细]

时间:2025-08-24 04:19 602人阅读

作者 | 赖文昕编辑 | 陈彩娴不久前,首届“人形机器人半程马拉松”在北京亦庄举办,为本就热度满满的具身智能行业再添了一把火。一共 20 支队伍组成的“钢铁生命竞赛”,让此前集中在实验室 demo 阶 ...[详细]

时间:2025-08-24 04:15 2708人阅读

作者:赖文昕编辑:陈彩娴鲜少有人关注到这样一个现象:在大模型的发展初期,「研发」与「产品」往往来自同一个群体——程序员。由于大模型技术的系统复杂,新一代大模型产品经理的数量稀少,程序员往往既是技术、又 ...[详细]

时间:2025-08-24 04:08 759人阅读

来源标题:电视剧《守诚者》今日开播!陈小春李治廷任达华热血集结,以忠诚勇毅护万家灯火热血冲锋警匪剧《守诚者》由紫荆文化集团有限公司、北京爱奇艺科技有限公司、北京春秋鸿文化传播股份有限公司出品,北京广播 ...[详细]

时间:2025-08-24 03:44 2729人阅读

来源标题:破界·共生:网络综艺的融合创新与价值跃升盛夏时节,网络综艺的蓬勃生机与创新活力在北京汇聚。 7月2日下午,第三届北京网络视听艺术大会网络综艺创作主题研讨成功举办。本次研讨以“&l ...[详细]

时间:2025-08-24 03:42 254人阅读

作者丨朱可轩编辑丨陈彩娴近期,上海交通大学与 AI Infra 创企魔形智能联合研究团队在由 IEEE 计算机协会主办的 HPCA 2025International Symposium on Hig ...[详细]

时间:2025-08-24 03:23 2590人阅读

随着「百模大战」进入白热化阶段,通用大模型的优势和弊端都已渐渐显露。与此同时,能应用在特定行业的垂直大模型,具备优越的落地场景,有更多来自市场的切实需求。利亚德集团的动作大模型便是行业垂直大模型的代表 ...[详细]

时间:2025-08-24 03:10 663人阅读

来源标题: 谭咏麟引爆上海LIVERSE首演,音宇宙重塑演唱会奢侈品新定义270度环绕巨幕前,谭咏麟《卡拉永远OK》的旋律裹挟着4D全息影像倾泻而下,1200名观众无论身处哪个角落,都如同站在舞台中心 ...[详细]

时间:2025-08-24 03:08 916人阅读

来源标题:骆言新剧《爱上海军蓝》燃情开播,飒爽戎装首次诠释军人形象7月2日,备受期待的当代军旅情感大剧《爱上海军蓝》正式登陆腾讯视频、爱奇艺双平台。在这部恢弘的军旅群像剧中,演员骆言饰演的王晨,以其角 ...[详细]

时间:2025-08-24 03:08 2043人阅读

2 月 16 号,马斯克在 X 上发布了一条自家 Grok 3 模型的发布预告。并配文“地球上最聪明的 AI”要来了。北京时间 2025 年 2 月 18 日中午,马斯克如约带领着 xAI 的工程师和 ...[详细]

时间:2025-08-24 02:56 692人阅读

ChatGPT-4的横空出世,让AI行业再一次柳暗花明。某AI企业人士如此评价GPT-4的进步:“GPT-3或3.5像一个六年级学生,而GPT-4像一个聪明的十年级学生。”即将毕业的小学生与新晋高中生 ...[详细]

时间:2025-08-24 02:56 736人阅读

“你总是心太软”“我等的船还不来,我等的人还不明白”,7月4日晚,任贤齐“齐迹”演唱会北京的首场演出在首都体育馆落下帷幕,歌迷们哼着熟悉的旋律从体育馆走出,兴奋劲儿久久不散。“我们去吃个夜宵吧,魏公村 ...[详细]

时间:2025-08-24 02:42 2654人阅读

来源标题: 美食纪录片《味道大师》上线,八大基础口味皆是时代镜像5月7日,由广州映象文化出品的美食纪录片《味道大师》在腾讯视频正式上线。这是国内首部以“中国人的八大基本口味”为 ...[详细]

时间:2025-08-24 02:37 2677人阅读

来源标题:独臂警察VS五人劫匪团!电影《插翅难逃》定档7月5日《插翅难逃》是西安华创文化传媒有限公司、东阳坏男孩影业有限公司、陕西慕威股权投资合伙企业有限合伙)出品,东阳坏男孩影业有限公司制作,西安华 ...[详细]

古装传奇剧《藏海传》厚重底蕴精良制作引关注 不落爽剧窠臼 淬炼人性光辉

来源标题:古装传奇剧《藏海传》厚重底蕴精良制作引关注 不落爽剧窠臼 淬炼人性光辉当古装剧陷入“大女主”与“爽剧”的创作窠臼时,《藏海传》以冷峻的现实主义

...[详细]

来源标题:古装传奇剧《藏海传》厚重底蕴精良制作引关注 不落爽剧窠臼 淬炼人性光辉当古装剧陷入“大女主”与“爽剧”的创作窠臼时,《藏海传》以冷峻的现实主义

...[详细]2025看东方·芭莎之夜暨超音尚派对燃擎上海 多元舞台引爆时尚音浪

来源标题:2025看东方·芭莎之夜暨超音尚派对燃擎上海 多元舞台引爆时尚音浪由《时尚芭莎》联合SMG看东方、华纳音乐打造的年度盛典——“2025 BAZAAR GA

...[详细]

来源标题:2025看东方·芭莎之夜暨超音尚派对燃擎上海 多元舞台引爆时尚音浪由《时尚芭莎》联合SMG看东方、华纳音乐打造的年度盛典——“2025 BAZAAR GA

...[详细] 据央视新闻消息,今日,外交部发言人毛宁主持例行记者会。有记者提问,美国总统特朗普7日表示,将从8月1日起分别对来自日本、韩国等14个国家的进口产物征收25%至40%不等的关税。外交部发言人毛宁表示,在

...[详细]

据央视新闻消息,今日,外交部发言人毛宁主持例行记者会。有记者提问,美国总统特朗普7日表示,将从8月1日起分别对来自日本、韩国等14个国家的进口产物征收25%至40%不等的关税。外交部发言人毛宁表示,在

...[详细] 来源:中国新闻周刊“外卖大战的输家已定,是我。”一位网友在小红书上说道。在连续点了5天外卖后,他打趣道自己已经可以“出栏”了。上周以来,持续不断的大额外卖券突然频频被塞到客户账户中,其慷慨程度更是前所

...[详细]

来源:中国新闻周刊“外卖大战的输家已定,是我。”一位网友在小红书上说道。在连续点了5天外卖后,他打趣道自己已经可以“出栏”了。上周以来,持续不断的大额外卖券突然频频被塞到客户账户中,其慷慨程度更是前所

...[详细] 9月19日,火山引擎在其举办的“V-Tech数据驱动科技峰会”上宣布,火山引擎数智平台VeDI推出“AI助手”,通过接入人工智能大模型,帮助企业提升数据处理和查询分析的效率。即使是不会写代码的运营人员

...[详细]

9月19日,火山引擎在其举办的“V-Tech数据驱动科技峰会”上宣布,火山引擎数智平台VeDI推出“AI助手”,通过接入人工智能大模型,帮助企业提升数据处理和查询分析的效率。即使是不会写代码的运营人员

...[详细]国家统计局:6月CPI同比上涨0.1%,由降转涨,核心CPI继续回升

国家统计局城市司首席统计师董莉娟解读2025年6月份CPI和PPI信息。6月份,扩内需、促消费政策持续显效,居民消费价格指数CPI)同比由上月下降转为上涨0.1%;环比下降0.1%,降幅比上月收窄0.

...[详细]

国家统计局城市司首席统计师董莉娟解读2025年6月份CPI和PPI信息。6月份,扩内需、促消费政策持续显效,居民消费价格指数CPI)同比由上月下降转为上涨0.1%;环比下降0.1%,降幅比上月收窄0.

...[详细]香港首个商业AI展「AI+ Power 2025」盛大开幕,本地及海外行业精英齐聚共探AI发展

香港,2025年6月5日)——由BUSINESS GOVirtualBGOV)主办的「AI+ Power 2025」今日在香港会议展览中心举行。作为香港首个聚焦商业AI应用的行业盛会,展会汇聚本地及海

...[详细]

香港,2025年6月5日)——由BUSINESS GOVirtualBGOV)主办的「AI+ Power 2025」今日在香港会议展览中心举行。作为香港首个聚焦商业AI应用的行业盛会,展会汇聚本地及海

...[详细] 我们应当如何实时监控自己大脑的健康状态?以马斯克的Neuralink为代表的侵入式脑机接口,过植入大脑皮层的线状电极直接读取神经信号,实现了高精准度信号采集和脑际交互。但是,侵入式脑机接口方案的风险也

...[详细]

我们应当如何实时监控自己大脑的健康状态?以马斯克的Neuralink为代表的侵入式脑机接口,过植入大脑皮层的线状电极直接读取神经信号,实现了高精准度信号采集和脑际交互。但是,侵入式脑机接口方案的风险也

...[详细]《姐妹不打烊》6月10日开播,“七乐美”欢乐集结,以东方之礼巡游壮阔山河!

来源标题:《姐妹不打烊》6月10日开播,“七乐美”欢乐集结,以东方之礼巡游壮阔山河!友情不惧时间,快乐永不打烊。由抖音和傲椒文化联合重磅推出的全女嘉宾治愈系旅行综艺《姐妹不打烊》已于6 月 10 日

...[详细]

来源标题:《姐妹不打烊》6月10日开播,“七乐美”欢乐集结,以东方之礼巡游壮阔山河!友情不惧时间,快乐永不打烊。由抖音和傲椒文化联合重磅推出的全女嘉宾治愈系旅行综艺《姐妹不打烊》已于6 月 10 日

...[详细]千寻智能解浚源:具身智能的 Scaling Law 已跨过起跑线丨具身先锋十人谈

作者 | 赖文昕编辑 | 陈彩娴不久前,首届“人形机器人半程马拉松”在北京亦庄举办,为本就热度满满的具身智能行业再添了一把火。一共 20 支队伍组成的“钢铁生命竞赛”,让此前集中在实验室 demo 阶

...[详细]

作者 | 赖文昕编辑 | 陈彩娴不久前,首届“人形机器人半程马拉松”在北京亦庄举办,为本就热度满满的具身智能行业再添了一把火。一共 20 支队伍组成的“钢铁生命竞赛”,让此前集中在实验室 demo 阶

...[详细]